Ollama : L'IA en local pour reprendre le contrôle (confidentialité & souveraineté)

Marre du cloud ? Découvrez comment faire tourner une IA puissante sur votre machine pour gagner en confidentialité, en autonomie et en sobriété.

L'IA locale : quand votre ordinateur devient le cerveau

On parle beaucoup d’IA “dans le cloud”, que ce soit avec ChatGPT, Claude, Mistral, Gemini ou Perplexity, et aussi, à juste titre, de son impact environnemental (je l’évoquais d’ailleurs dans cet article : L’impact environnemental de l’IA), de souveraineté des données ou encore de respect de la vie privée.

Mais une autre tendance émerge de plus en plus, celle des modèles d’IA exécutés en local, directement sur son ordinateur3.

Concrètement, au lieu d’envoyer vos données vers les serveurs d’OpenAI ou de Google, vous faites tourner le modèle chez vous, sur votre machine. C’est ce que je teste depuis plusieurs mois avec Ollama, un outil qui permet d’installer localement des modèles open source comme Llama 3.2 (Meta), Mistral ou GPT-OSS, le modèle open source d’OpenAI.

L’outil est disponible sur MacOS, Windows et Linux, et propose désormais une interface graphique native : plus besoin du terminal (et de lignes de commande…), tout se fait depuis une appli claire et fluide. Et sur mon MacBook Pro personnel, l’expérience est étonnamment fluide. Pas besoin de connexion internet, aucun transfert de données et une vraie sensation de liberté.

Confidentialité et souveraineté : pourquoi l'IA locale est une force

Une solution complémentaire que je teste depuis plusieurs mois et que je vous encourage vraiment à explorer, c’est l’IA locale. Avec des outils comme Ollama, vous pouvez installer des modèles (comme ceux de Mistral par exemple) directement sur votre ordinateur ou votre serveur.

La force ?

- Confidentialité renforcée : vos données ne quittent pas votre machine (sauf si vous les synchronisez ailleurs).

- Coûts maîtrisés : pas d’abonnement, pas de tokens à payer.

- Sobriété d’usage : votre processeur travaille ponctuellement, donc moins d’allers-retours vers le cloud quand ce n’est pas nécessaire.

- Souveraineté : vous êtes moins à la merci d’une coupure de service ou d’une hausse de prix unilatérale d’une plateforme américaine.

- Disponibilité hors ligne : le modèle fonctionne même sans connexion internet.

Usage pro vs usage perso : les limites réelles du local

Tout n’est pas parfait, sinon tout le monde l’utiliserait déjà. Sur le papier, c’est parfait pour un usage personnel. À l’échelle d’une structure, c’est moins évident.

Cela fonctionne surtout si vous avez un poste dédié, un minimum de support IT et un cadre d’usage clair. Il faut aussi un ordinateur assez récent (au moins 16GB de RAM recommandés) et accepter de mettre à jour les modèles soi-même.

Les modèles pèsent plusieurs gigas : par exemple GPT-OSS:20B fait environ 14Go et GPT-OSS:120B monte à 65Go. Pour les plus gros modèles, il faut accepter un peu de latence au démarrage. Mais c’est réel, faisable et, pour certains usages, c’est vraiment pertinent.

☁️ En mode cloud (quand vous êtes sur chatgpt.com par exemple), chaque requête passe par les serveurs d’OpenAI, Google ou Anthropic. Ces serveurs tournent en continu pour des millions d’utilisateurs, ce qui multiplie la consommation d’énergie.

💻 En mode local, c’est votre ordinateur qui exécute le calcul. Le processeur ou la carte graphique sont sollicités quelques secondes, puis tout s’arrête. L’impact reste donc bien moindre, comparable à une tâche de calcul classique (et au pire comme du montage vidéo).

L’IA locale ne remplacera pas les grands modèles mais elle ouvre vraiment une voie plus libre, plus maîtrisée et plus sobre… que je trouve super intéressante. Une alternative prometteuse !

☕ Si le sujet vous intéresse, écrivez-moi, je serai ravi d’en discuter :)

L'inspiration : reprendre la main sur la technologie

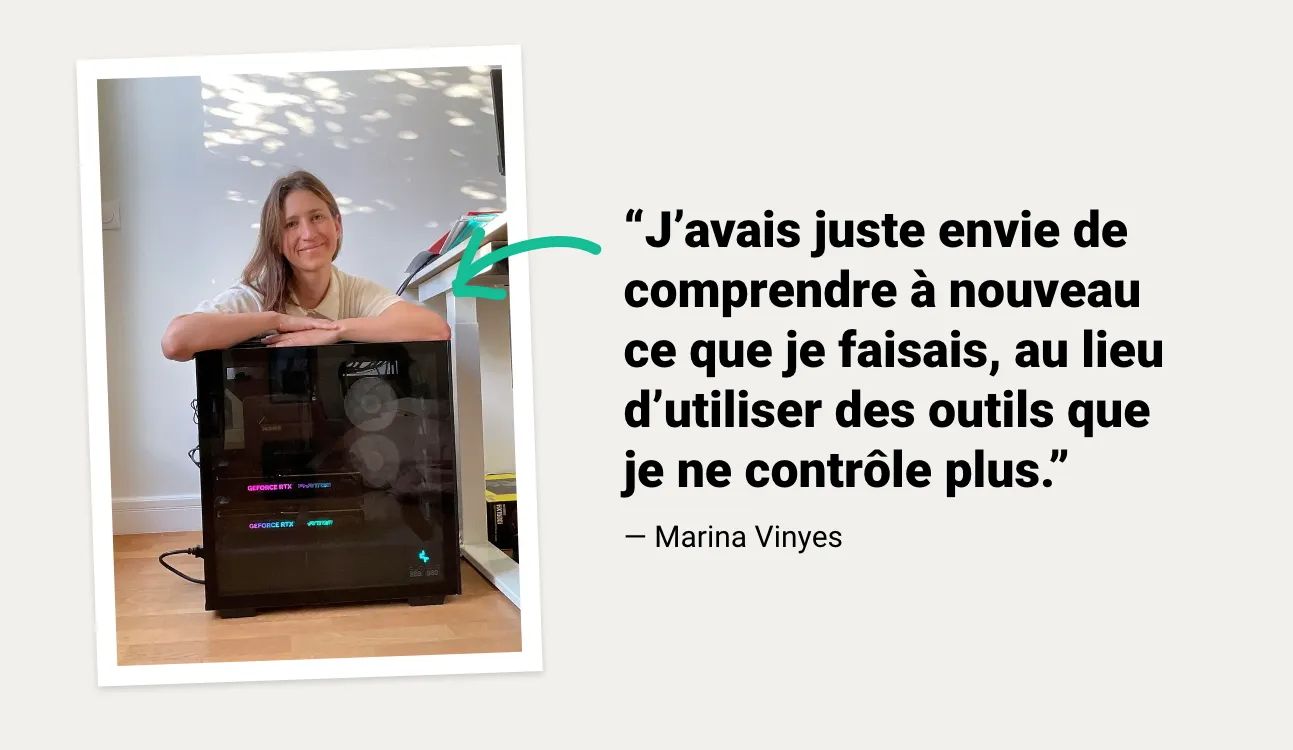

Cette histoire illustre parfaitement ce besoin croissant de reprendre la main sur ses outils. Marina Vinyes, ingénieure en IA passée par Criteo, a quitté un poste prestigieux pour créer son propre modèle de langage. Pas pour concurrencer OpenAI ;), mais pour comprendre à nouveau ce qu’elle faisait, sans dépendre d’outils devenus trop complexes ou opaques.

Avec 2 GPU et beaucoup de curiosité, elle a fini par contribuer au projet open-source Numina, une IA qui rivalise désormais avec certains modèles des géants du secteur.

🎧 Un épisode passionnant du podcast Tronche de Tech, à écouter ici :

Foire aux questions

Est-ce que c'est vraiment plus écologique d'utiliser l'IA sur mon PC ?

Oui. Dans le cloud, une requête ChatGPT consomme environ 10 fois plus d'énergie qu'une simple recherche Google. En local, ton ordinateur n'utilise de l'énergie que pendant les quelques secondes de calcul de la réponse, évitant ainsi de solliciter des centres de données qui tournent 24h/247.

Est-ce que je peux utiliser l'IA locale pour mon entreprise ?

C'est faisable, mais plus complexe qu'en solo. Il vous faudra un support technique pour gérer l'infrastructure et s'assurer que les postes de vos collaborateurs sont assez puissants (minimum 16 Go de RAM). C'est une excellente option pour les structures manipulant des données confidentielles.

Est-ce que je vais devoir taper des lignes de code ?

C'était le cas au début, mais plus maintenant ! Avec l'interface graphique native d'Ollama, l'installation ressemble à celle de n'importe quel logiciel classique. C'est devenu très accessible pour tout utilisateur motivé.

Nicolas François

Nicolas François