Les réseaux sociaux face aux contenus générés par l’IA : vers plus de transparence ?

L’IA générative bouscule nos fils d’actualité. Entre images ultra-réalistes créées en quelques secondes, deepfakes plus vrais que nature et montages express réalisés avec Grok, Midjourney ou Photoshop, il devient de plus en plus difficile de savoir ce qui est vrai… ou généré.

Et la question se pose : comment les réseaux sociaux réagissent-ils à cette vague de contenus IA ? Peut-on encore faire confiance à ce que l’on voit défiler chaque jour sur LinkedIn, Instagram ou TikTok ?

Voici un petit tour d’horizon (non exhaustif mais concret) des mesures mises en place pour encadrer ces contenus — avec un regard critique et quelques questions en suspens.

Pourquoi les contenus générés par IA posent question

L’arrivée massive des contenus générés par IA crée un vrai flou dans nos usages numériques. Ce n’est plus seulement une question de fake news, mais de perte de repères visuels et émotionnels. Une photo d’un volcan en éruption ? D’un événement historique ? D’un site touristique ? De plus en plus souvent, c’est une image synthétique, sans que cela soit mentionné...

Ca ne serait pas forcément problématique si c’est assumé.

Mais quand ça ne l’est pas, la confiance s’effrite… et les algorithmes continuent de propager ces contenus, souvent mieux optimisés que les vrais.

Les réponses des plateformes : quelles mesures concrètes ?

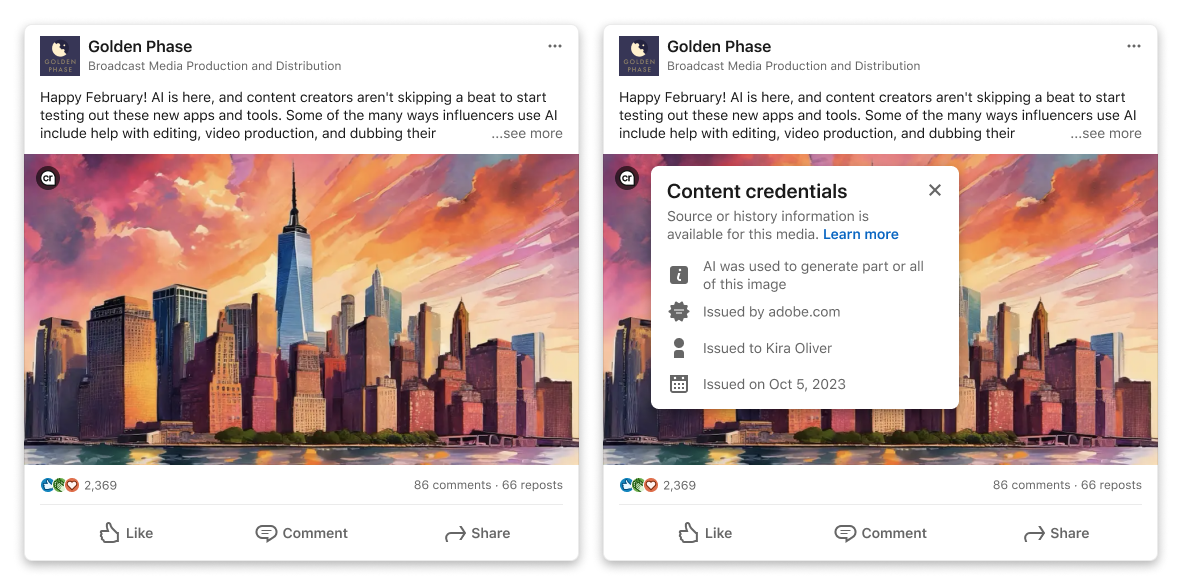

LinkedIn : le badge “Cr” pour signaler les contenus IA

LinkedIn teste depuis quelques mois une étiquette “Cr” (pour “Created with AI”) visible sur certaines publications. Basée sur le standard C2PA, cette technologie permet de retracer l’origine d’un contenu en un clic.

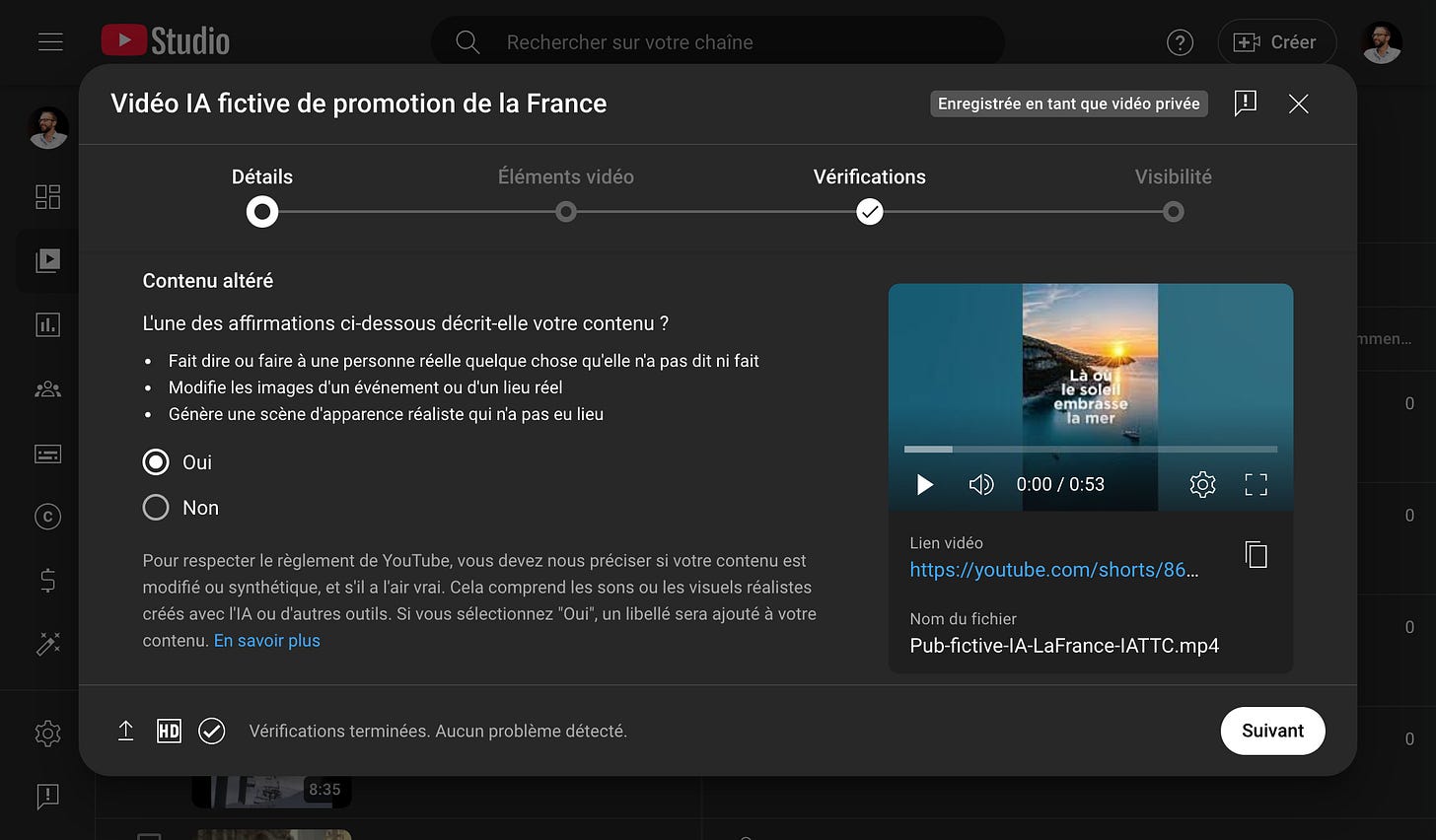

YouTube : des mentions obligatoires et des sanctions prévues

YouTube impose désormais aux créateurs de signaler explicitement les contenus modifiés ou générés par IA, en cochant une case spécifique lors du dépôt d’une vidéo.

En cas de non-respect, des sanctions sont prévues (retrait de la vidéo, démonétisation…). Une bonne chose sur le principe mais encore faut-il que ce soit réellement contrôlé.

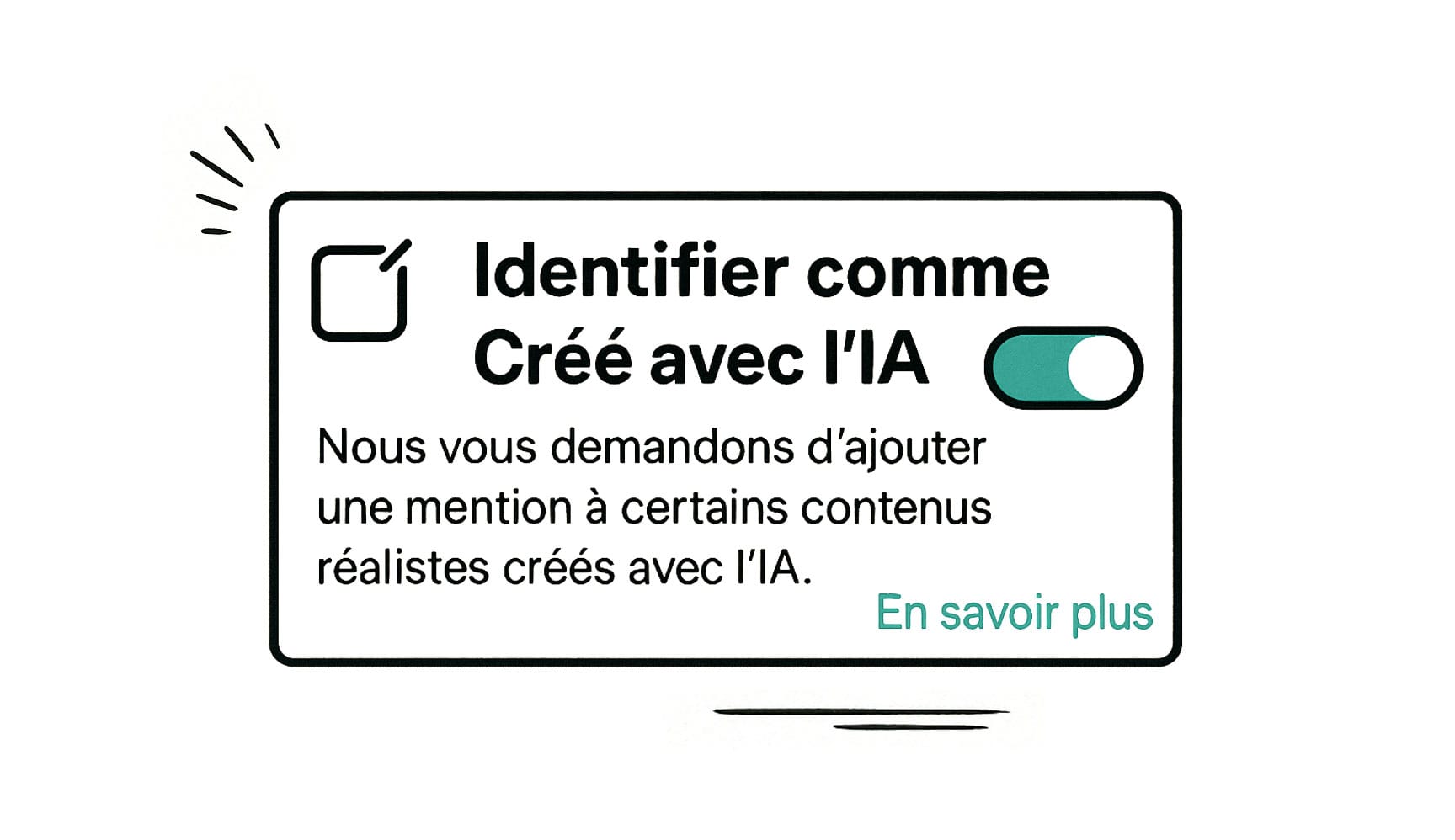

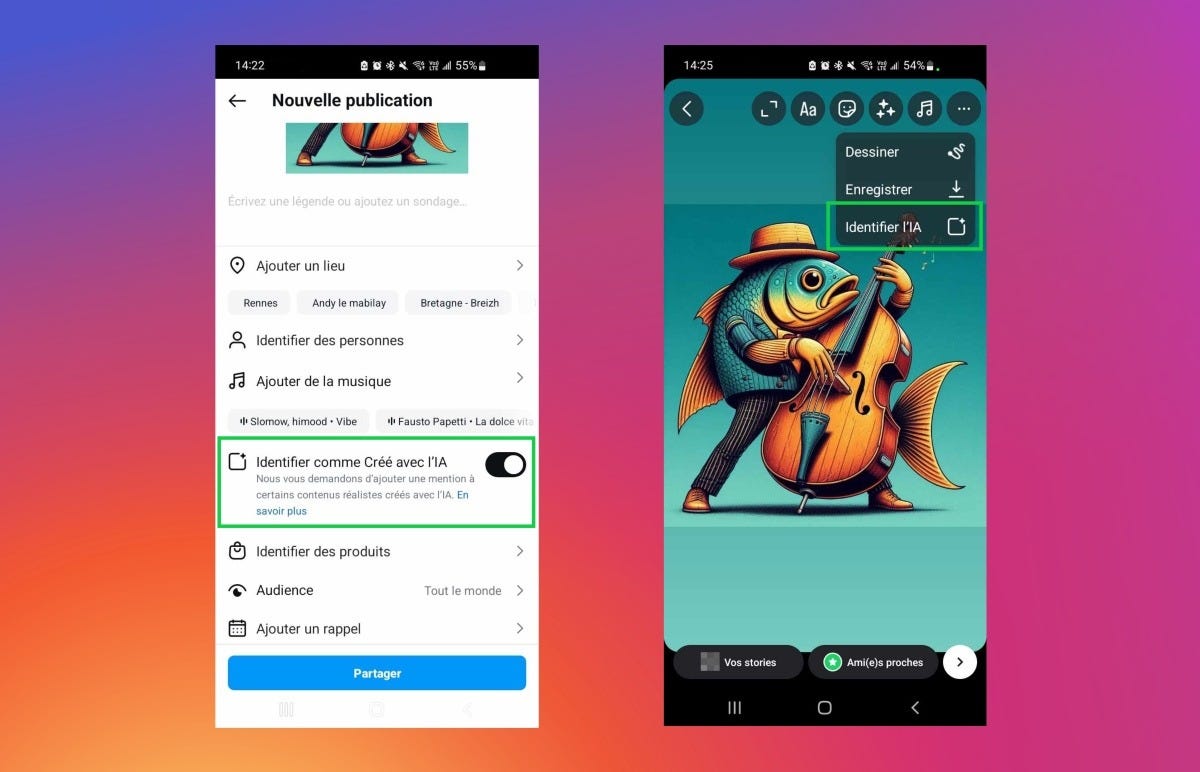

Meta (Facebook, Instagram, Threads) : étiquetage automatique… ou presque

Meta a annoncé que les contenus générés par IA seraient automatiquement étiquetés sur ses plateformes. En réalité, cela repose encore beaucoup sur la déclaration des utilisateurs.

Autrement dit : à moins d’un signalement, une vidéo deepfake peut passer entre les mailles du filet. Là aussi, l’intention est bonne, mais l’efficacité reste à prouver.

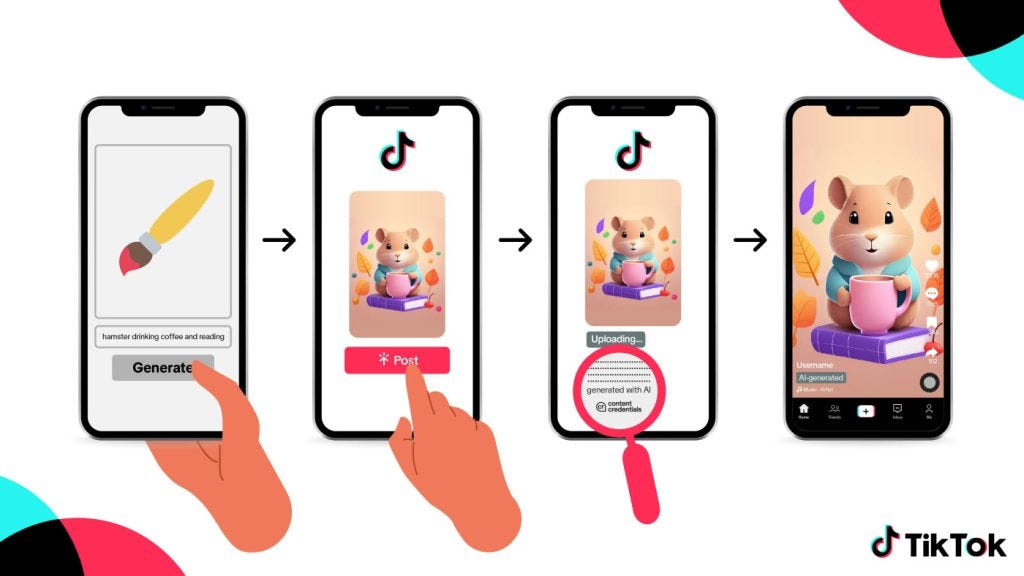

TikTok : des règles strictes sur le papier

TikTok indique clairement qu’il interdit les deepfakes trompeurs et applique le standard C2PA. Dans la pratique, des vidéos IA continuent de circuler sans mention… et certaines deviennent même virales (comme la vidéo hypertruquée du Vieux-Québec qui est devenue virale sur TikTok).

Vers une nouvelle éthique visuelle ?

Ces efforts vont dans le bon sens. Mais ils semblent bien faibles face à la vague de contenus IA qui déferle sur les plateformes. La question n’est plus seulement “qui a créé cette image”, mais “pourquoi et avec quelles intentions ?”

L’IA permet d’illustrer, de simplifier, de tester… mais elle ne doit pas brouiller le lien avec le réel. Dans le secteur du tourisme par exemple, cela pose évidemment des questions de transparence et de confiance. Montrer un lieu qui n’existe pas peut être artistique… ou trompeur.

🙋 Et nous, utilisateurs, dans tout ça ?

On peut déjà :

- s’habituer à regarder les visuels avec un œil plus critique

- exiger plus de clarté sur la nature des contenus

- et pourquoi pas, valoriser les contenus authentiques, même moins “parfaits”

En résumé

Face à la prolifération des contenus générés par IA, les plateformes sociales avancent (parfois timidement) vers plus de clarté. Si les intentions sont là, l’efficacité des dispositifs reste encore inégale.

Dans ce paysage en mouvement, la vigilance et la pédagogie deviennent des repères essentiels pour préserver un lien de confiance, sans renoncer à l’innovation.

Explorons l'IA ensemble

RDV chaque mois pour explorer ensemble le potentiel de l’IA dans le tourisme, simplement et sans jargon compliqué ☕️

S'abonner à la newsletter Nicolas François

Nicolas François